فایل robots.txt چیست و چرا برای سئو سایت اهمیت دارد؟

- robots.txt چیست؟

- نحوه عملکرد فایل robots.txt

- اهمیت استفاده از فایل robots.txt

- انواع دستورات در فایل robots.txt(استفاده از عبارت دستورات قابل پشتیبانی در فایل robots.txt)

- قرار دادن robots.txt در سرچ کنسول گوگل

- نکاتی درباره استفاده بهتر از فایل روبوت

- خلاصه نهایی؛ چرا robots.txt باید در جعبه ابزار هر سئوکار باشد؟

- سوالات متداول

وقتی موتورهای جستجو میخواهند صفحات یک سایت را ایندکس کنند، تعداد صفحات زیاد است و اغلب نمیدانند باید از کجا شروع کنند! شما میتوانید بهعنوان سئو کار یا مدیر سایت یک فایل robots.txt آماده کنید، این فایل متنی کوچک اما کاربردی همان راهنمایی است که به رباتهای خزنده گوگل میگوید کدام بخشهای سایت را بررسی و کدام قسمتها را نادیده بگیرند. جلوگیری از اتلاف منابع سرور و بهبود سئو سایت از مزایای داشتن robots.txt است. البته ساخت و نحوه قرار دادن این فایل در ریشه سایت نیز بسیار مهم است که در ادامه این مقاله از مجله آکادمی سئو معین حسینی بیشتر به آنها میپردازیم.

robots.txt چیست؟

فایل “robots.txt” یک فایل متنی ساده با فرمت .txt است که در ریشه سایت قرار میگیرد و نقش راهنما برای رباتها و خزندههای موتورهای جستجو را دارد. با استفاده از این فایل میتوان مشخص کرد کدام صفحات سایت ایندکس و فرصت راه یافتن به نتایج گوگل را پیدا کنند و کدام صفحات پنهان بمانند. در واقع robots.txt ابزاری قدرتمند برای مدیریت نحوه نمایش سایت در موتورهای جستجو و بهبود سئو است، اما باید توجه داشت که برخی بدافزارها و رباتهای مخرب به قوانین آن پایبند نیستند و ممکن است تهدیدی برای سایت باشند.

اگر به دنبال یادگیری عمیقتر مدیریت چنین فایلهایی هستید، شرکت در دوره جامع اموزش سئو میتواند به شما کمک کند تا به شکل اصولیتر از ابزارهای سئو استفاده کنید.

نحوه عملکرد فایل robots.txt

فایل “robots.txt بخشی از پروتکل استاندارد REP است که به رباتهای موتور جستجو دستور میدهد کدام بخشهای سایت را بخزند و از کدام بخشها دوری کنند. زمانیکه خزندهای مانند “Googlebot” برای ایندکس کردن وارد سایت میشود، ابتدا فایل روبوت را بررسی کرده و سپس بر اساس دستورالعملهای آن مسیر خزش خود را مشخص میکند. در صورتی که سایت شما فایل robots.txt وردپرس را نداشته باشد، رباتهای گوگل فرض را بر آزاد بودن خزش تمام سایت میگذارند و با دنبال کردن لینکها، بهروش خزش عنکبوتی کل صفحات را بررسی میکند. این روش زمانبر است و میتواند با ایندکس کردن صفحات غیر مرتبط با تارگت سئویی شما باعث افت رتبه سایت شود.

از طریق لینکها

خزندههای موتور جستجو برای حرکت در سایتها از لینکها استفاده میکنند، یعنی برای اینکه محتوای سایت را بررسی و به سایت رتبه بدهند از طریق لینکها به تک تک صفحات سایت رفته و سایت را ایندکس میکنند. اما اگر از تنظیم فایل robots txt انجام شده باشد، رباتها صفحاتی را بررسی میکنند که در این فایل ذکر شده و بهسراغ صفحات دیگر نمیروند. در واقع فایل روبوت برای این است ربات بداند کدام مسیرها و لینکها مجاز هستند و کدامها محدود شدهاند. به این ترتیب رباتها فقط روی لینکها و صفحات مجاز تمرکز کرده و از ورود به مسیرهایی که مسدود شدهاند بهصورت کامل صرفنظر میکنند.

از طریق فایل robots.txt

وقتی یک خزنده وب وارد سایت میشود، اولین کارش بررسی فایل robots.txt در روت دامنه است. این فایل تعیین میکند که رباتها هنگام دنبالکردن لینکها در سایت، به کدام مسیرها اجازه ورود دارند و از کدام مسیرها باید صرفنظر کنند. در واقع فایل robots.txt مانند یک فیلتر عمل میکند؛ یعنی اگر لینکی به صفحهای وجود داشته باشد اما در robots.txt به آن “Disallow” داده شده باشد، خزنده آن لینک را دنبال نمیکند. به این ترتیب مسیر حرکت رباتها در میان لینکهای داخلی و خارجی سایت، دقیقا بر اساس قوانینی که در این فایل نوشته شده، کنترل و مدیریت میشود.

اهمیت استفاده از فایل robots.txt

اگر میخواهید براساس خواستههای خود رباتهای خزنده موتور جستجو را فقط به صفحات خاصی از سایت هدایت کنید، داشتن فایل روبوت و اعمال دستورات robots txt ضروری است. این فایل علاوهبر بهبود سئو و بهینهسازی منابع سرور، میتواند از نمایش بخشهای غیرضروری یا حساس سایت در نتایج جستجو جلوگیری کند. همچنین میتوانید در فایل robots.txt مسیر سایتمپ (Sitemap) را مشخص کنید تا گوگل راحتتر صفحات سایت را شناسایی کند. بهصورت کلی مزایای داشتن robots.txt عبارتاند از:

- جلوگیری از ایندکس شدن صفحات غیرضروری یا تکراری (مثل فیلتر محصولات یا صفحات تستی)

- بهینهسازی فرآیند خزیدن (Crawl Budget) و تمرکز موتور جستجو روی صفحات مهم

- کاهش فشار روی سرور با محدود کردن دسترسی رباتها به بخشهای سنگین سایت

- افزایش امنیت نسبی با مخفی کردن بخشهای مدیریتی یا خصوصی سایت

- کمک به بهبود تجربه کاربری در نتایج جستجو با نمایش صفحات ارزشمند

انواع دستورات در فایل robots.txt(استفاده از عبارت دستورات قابل پشتیبانی در فایل robots.txt)

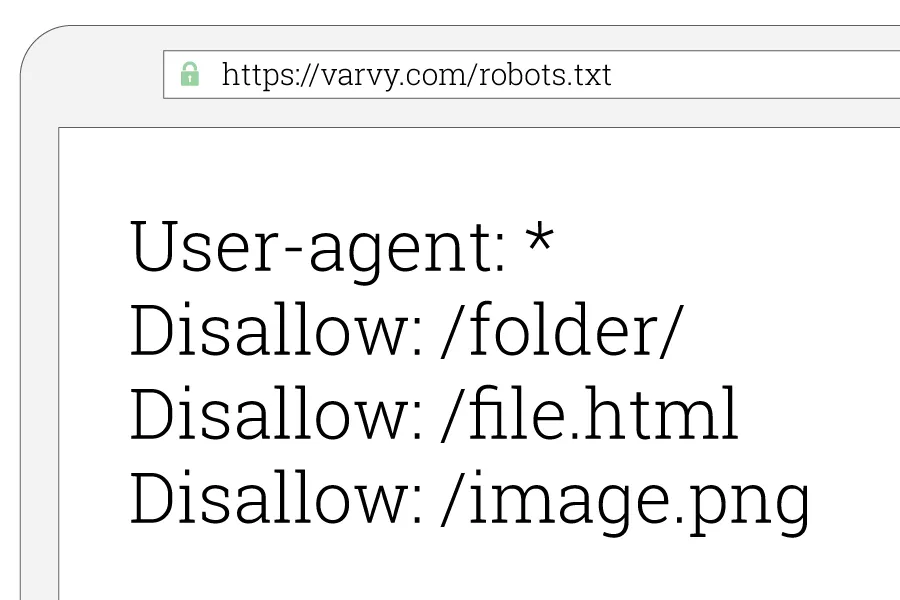

داشتن robots.txt وقتی میتواند تاثیر لازم را داشته باشد که در آن از دستورات مناسب استفاده کنید. فایل robots txt در وردپرس حاوی مجموعهای از دستورات قابل پشتیبانی است که هر کدام وظیفه مشخصی برای هدایت خزندهها بر عهده دارند و با توجه به اهداف تیم سئو نوشته شدهاند. این دستورات به رباتها میگویند چه صفحاتی را بخزند و چه صفحاتی را نادیده بگیرند. مهمترین دستورات بهینه سازی فایل robots txt در جدول زیر ذکر شده است.

| دستور (Directive) | توضیح | نمونه استفاده |

| User-agent | مشخص میکند که قوانین بعدی برای کدام ربات (موتور جستجو) اعمال شود. | User-agent: * → همه رباتها |

| Disallow | مسیر یا صفحهای که نباید توسط رباتها کراول شود. | Disallow: /admin/ |

| Allow | اجازه دسترسی به یک مسیر خاص )معمولا در ادامه یک Disallow برای استثنا کردن(. | Allow: /admin/public/ |

| Sitemap | معرفی لینک فایل نقشه سایت (XML Sitemap) به موتورهای جستجو. | Sitemap: https://example.com/sitemap.xml |

| Crawl-delay | تعیین زمان تاخیر بین درخواستهای متوالی رباتها (همه موتورهای جستجو پشتیبانی نمیکنند). | Crawl-delay: 10(۱۰ ثانیه فاصله) |

| Host | تعیین نسخه اصلی دامنه (با www یا بدون www). بیشتر توسط Yandex پشتیبانی میشود. | Host: example.com |

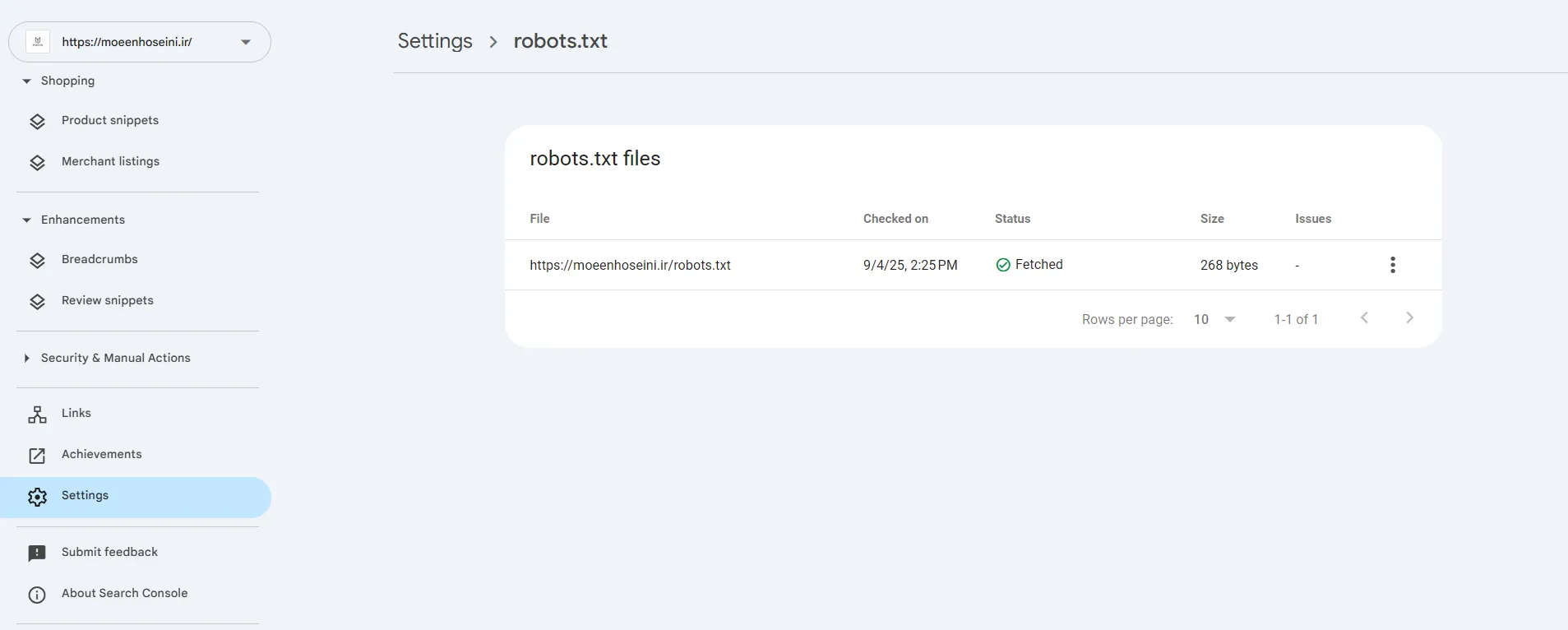

قرار دادن robots.txt در سرچ کنسول گوگل

برای قرار دادن و مدیریت فایل robots.txt در سرچ کنسول گوگل، کافیست ابتدا این فایل را در ریشه دامنهی سایت خود (مانند example.com/robots.txt) آپلود کنید و سپس وارد سرچ کنسول شوید. در بخش “Settings” یا از طریق ابزار قدیمی robots.txt Tester میتوانید صحت فایل را بررسی کنید، خطاها را ببینید و مطمئن شوید گوگل دستورات شما را درست میخواند. در واقع سرچ کنسول به شما این امکان را میدهد تا مطمئن شوید مسیرهایی که مسدود یا مجاز کردهاید، بهصورت دقیق و طبق برنامه برای رباتهای گوگل اعمال میشوند.

نکاتی درباره استفاده بهتر از فایل روبوت

رعایت برخی نکات در حین آمادهسازی و نوشتن دستورات فایل robots.txt، به شما کمک میکند تا بتوانید نتیجه بهتری از ساخت این فایل بگیرید و منابعی مانند سرور را بهتر مدیریت نمایید. این نکات عبارتاند از:

- تعیین نحوه کراول کردن رباتها و ایندکس کردن صفحات در سایت با جلوگیری از خزش صفحات تکراری، تستی یا مدیریتی

- استفاده صحیح از Allow و Disallow؛ تعیین استثنا برای ایندکس صفحات مهم داخل پوشهها

- مدیریت کرول باجتها و ایجاد فضایی متمرکز برای ایندکس صفحات ارزشمند

- بررسی و اصلاح فایل در ابزارهایی مثل Search Console

خلاصه نهایی؛ چرا robots.txt باید در جعبه ابزار هر سئوکار باشد؟

در این محتوا سعی کردیم شما را با فایل robots.txt بهعنوان ابزاری ساده اما حیاتی برای مدیریت نحوه خزش و ایندکس سایتها آشنا کنیم. با استفاده صحیح از فایل robots.txt میتوان صفحات مهم را اولویتبندی، صفحات غیرضروری را محدود و منابع سرور را بهینه کرد؛ نتیجه آن ایندکس بهتر و بهبود مستقیم سئو سایت است. آشنایی با دستورات قابل پشتیبانی و رعایت نکات بهینهسازی آن، میتواند تجربه بهتری در مدیریت سایت برای مدیران وب فراهم کند. برای یادگیری کامل و ساخت robots.txt بهصوت حرفهای و سایر تکنیکهای سئو میتوانید در دورههای آکادمی سئو معین حسینی ثبت نام کنید که مسیر بهینهسازی سایت را بهطور عملی و کاربردی نشان میدهند.

سوالات متداول

۱. فایل robots.txt کجاست؟

فایل robots.txt یک راهنمای ساده برای موتورهای جستجو است و باید در ریشه دامنه سایت قرار گیرد (مثلا example.com/robots.txt) تا رباتهای موتور جستجو بتوانند آن را شناسایی کنند.

۲. یک فایل Robots.txt باید حاوی چه چیزی باشد؟

یک فایل روبوت استاندارد و حرفهای باید شامل دستوراتی مانند “User-agent”، “Disallow”، “Allow”، “Crawl-delay” و “Sitemap” باشد تا مسیرهای مجاز و غیرمجاز برای خزندهها مشخص شود.

۳. چرا باید از فایل robots.txt برای سایت خود استفاده کنیم؟

فایل robots.txt به شما کمک میکند دسترسی رباتها به بخشهای غیرضروری سایت را محدود کنید تا منابع سرور بهینه مصرف شوند و تمرکز موتورهای جستجو روی صفحات مهم قرار گیرد. این کار باعث بهبود سئو میشود، چون خزندهها سریعتر و بهتر محتوای ارزشمند شما را ایندکس میکنند.

منبع این مقاله: https://developers.google.com/search/docs/crawling-indexing/robots/intro